논문: Higgins, Irina, et al. “beta-vae: Learning basic visual concepts with a constrained variational framework.” (2016).

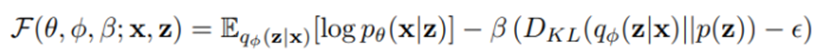

모델이 학습하는 테스크나 주어진 데이터셋에 적절한 representation을 찾게 되면 모델의 학습의 정확도가 올라간다. 이러한 점에서 특성에 대한 disentangled representation을 잘 찾는 것은 매우 중요하다. 본 논문에서는 disentangled representation 학습을 위해 beta-variational auto encoder (beta-vae)를 제안한다. 제안된 beta VAE은 다음과 같다.

결국 latent factor인 q(z|x)가 conditionally independent factor v의 disentangled representation을 잘 학습하여야 한다. 이를 위해서는 beta를 1보다 큰 값으로 설정해주어야 하는데, beta가 커질수록 disentangled representation을 잘 학습할 수 있지만, 다시 input을 reconstruction할 때의 정확도는 떨어지게 된다.

논문에서는 disentangle의 정도를 측정하기 위해 disentanglement metric을 제안한다. 데이터를 구성하는 특징들 중에 모양, 색 같이 conditionally independent한 interpretable property들이 있다. 이러한 representation들이 v에 의해 disentangled 되는지에 초점을 두는데, 선형 분류기를 통과한 정확성을 disentanglement metric score로 사용한다.

Beta-VAE는 비지도학습 방법임에도 불구하고 좋은 성능을 보여주었고, 기존의 infogan에서와 같이 큰 데이터셋에서 적용하기 힘들다는 단점을 보완하였다. 또한 하이퍼파라미터 베타를 조절함으로써 disentanglement를 조절할 수 있다.

'컴퓨터공학 > AI' 카테고리의 다른 글

| DeepSIM: Image Shape Manipulation from a Single Augmented Training Sample (ICCV 2021 Oral) 리뷰 (0) | 2021.12.01 |

|---|---|

| Domain-adversarial training of neural networks 요약 (0) | 2021.12.01 |

| Xgboost: A scalable tree boosting system (0) | 2021.12.01 |

| Lightgbm: A highly efficient gradient boosting decision tree (0) | 2021.12.01 |

| Auto-encoding variational bayes 요약 (0) | 2021.12.01 |